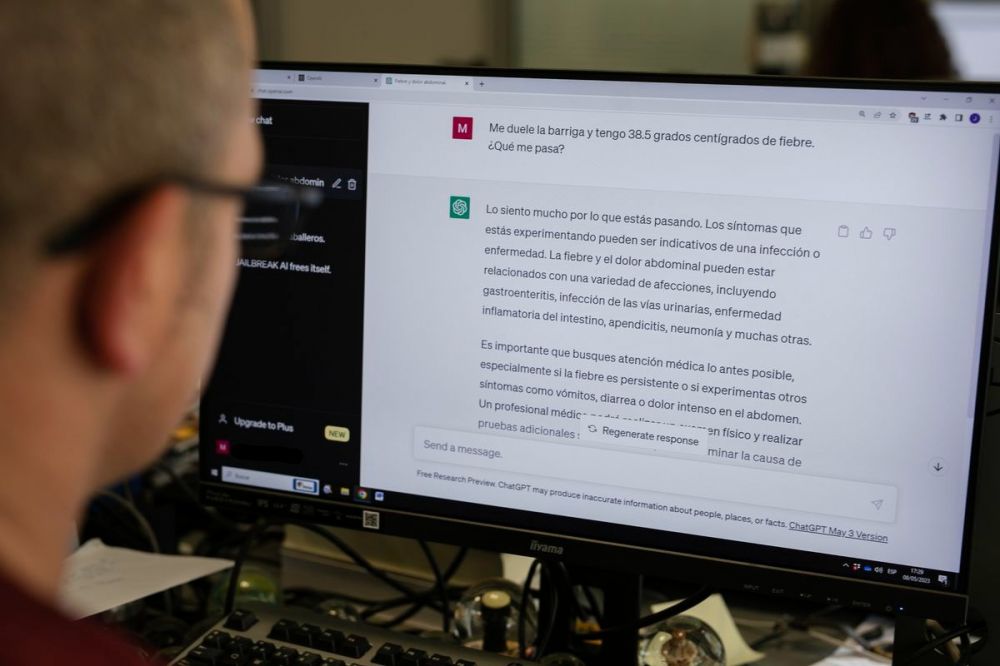

Doctor ChatGPT: cara y cruz de la inteligencia artificial en la consulta

Un estudio muestra que el ‘chatbot’ mejora a los médicos con consejos más empáticos y de calidad ante preguntas de pacientes, pero los expertos reclaman que siempre haya supervisión final del facultativo.

Ante la consulta de un ciudadano sobre el riesgo de morir después de tragar un palillo de dientes, dos respuestas.

La primera señala que entre dos o seis horas después de la ingesta, es probable que haya pasado ya a los intestinos y, además, mucha gente traga palillos sin que pase nada, pero advierte de que si siente “dolor de estómago”, vaya a urgencias. La segunda respuesta va en la misma línea e insiste en que, aunque es normal la preocupación, es poco probable que ocurra un daño grave tras tragar un palillo porque está hecho de madera, que no es un material tóxico ni envenena, y es un utensilio pequeño; sin embargo, agrega, si tiene “dolor abdominal, dificultad para tragar o vómitos”, debe acudir al médico: “Es comprensible que te sientas paranoico, pero trata de no preocuparte demasiado”, le consuela.

Las dos respuestas dicen lo mismo en el fondo, pero cambian en las formas. Una es más aséptica y escueta; otra, más empática y detallada. La primera ha sido generada por un médico, de su puño y letra, y la segunda, por ChatGPT, la herramienta generativa de inteligencia artificial (IA) que ha revolucionado el planeta en los últimos meses.

El estudio en el que se enmarca este experimento, publicado en la revista Jama Internal Medicine, quiso profundizar en el papel que podrían tener los asistentes de IA en medicina y comparó las respuestas que daban médicos reales y el chatbot a cuestiones de salud planteadas por ciudadanos en un foro de internet. Las conclusiones, tras el análisis de las respuestas por parte de un panel externo de profesionales de la salud que desconocía quién había respondido qué cosa, es que, en el 79% de las veces, las explicaciones de ChatGPT eran más empáticas y de mayor calidad.